Поисковики не ищут в интернете – они ищут в своей поисковой базе (в своем индексе).

Коммерческие, информационные, новостные документы (страницы) появляются в результатах поиска только после того как они прошли индексирование страниц в Yandex и Гугл. Другими словами, чтобы ваша страница появилась в поиске – она должна сначала проиндексироваться. В данной статье рассмотрим, что такое индексация, зачем она нужна, как ее ускорить.

Содержание статьи:

- Что такое индексация сайта и как она работает

- Как проверить находится ли сайт в индексе

- Как проверить индексацию конкретной страницы

- Как отправить сайт на индексацию?

– Автоматическое добавление

– Добавление вручную - От чего зависит индексация (факторы влияющие на индексацию)

- Как ускорить индексацию сайта

– Особенности ускоренной индексации сайтов поисковыми системами - Управление сканированием сайта

- Проблемы с индексированием сайта или частые ошибки

- Почему не индексируется сайт? Частые ошибки

- Как закрыть сайт от индексации?

Вывод

1. Что такое индексация сайта и как она работает

Индексация сайта – это обход роботом (поисковым ботом) сайта и включение его страниц в базу поисковой системы.

Чтобы сайт и его страницы (документы) появился в поиске, он должен пройти 4 основных этапа:

– Сначала робот узнает о сайте: от владельца или сам находит его по внешним ссылкам;

– Робот планирует обход сайта;

– После чего отправляет запрос серверу и получает в ответ контент;

– Отправляет контент в базу (в индекс).

Сканирование и проверка – неотъемлемая часть продвижения ресурса. От усешности сканирования при индексации сайта зависит, сколько URL появится в доступной для пользователей поисковой выдаче. Работу по анализу контента выполняют поисковые боты (или поисковые пауки).

Робот сканирует и изучает весь html-код, то есть все составляющие страницы, включая текстовый, видео контент и изображения. Поэтому важно не только корректно заполнять разделы ресурса, но и прописывать теги <title>, <description>, <H1>, <p> и прочие. Важно следить за перелинковкой и картой ресурса.

2. Как проверить находится ли сайт в индексе

С понятием индексации разобрались – это работа поисковых роботов, которые заходят на ресурс и сканируют его содержимое. Проверить, запустился ли этот процесс и находиться ли сайт в индексе поисковой системы и сколько в нем страниц, можно 4 способами:

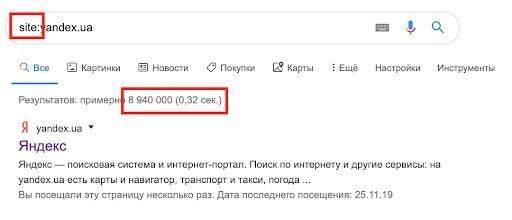

– Зайдите в Google и воспользуйтесь поисковым оператором “site:yousite.com”;

Определить проверенное количество URL можно через оператора site. Работает он и в Яндексе, и в Гугле. Число проанализированного материала в двух поисковиках может разнится: Google включает в поиск много мусора.

– Воспользоваться Яндекс.Вебмастер и Google Search Console;

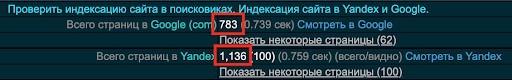

– Использовать сервисы, например XSEO.in;

– Используйте плагин для браузера, например RDS.

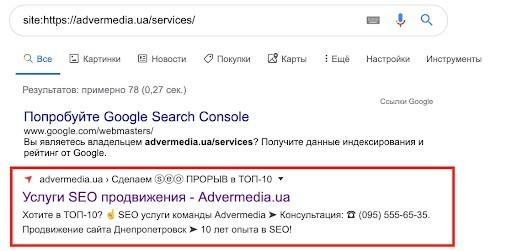

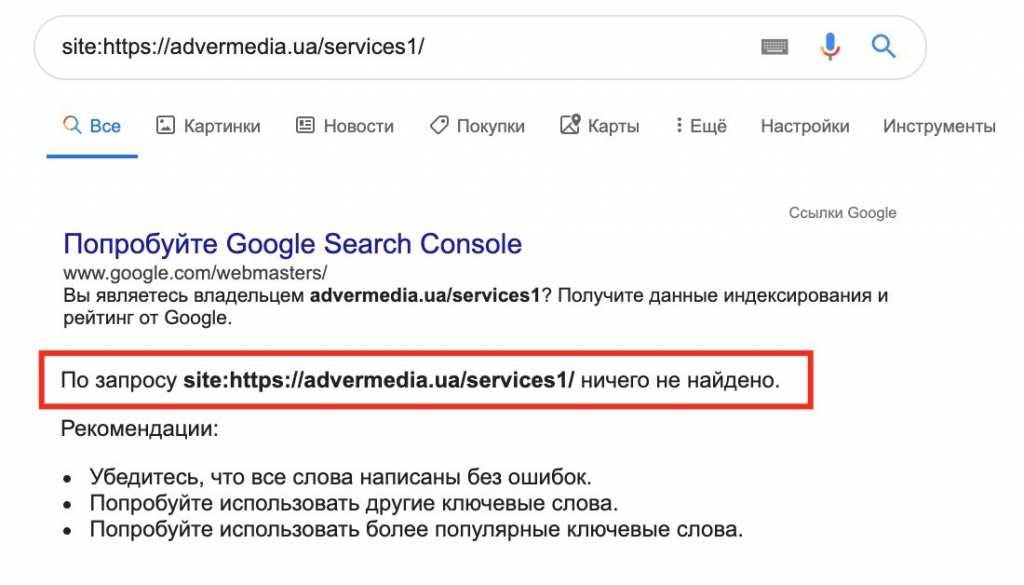

3. Как проверить индексацию конкретной страницы

Самый простой метод проверить индексирование сайта – написать в поисковой строке команду: site:[адрес страницы].

Так вы быстро проверите есть ли страница в индексе.

Страница в индексе:

Страница НЕ в индексе:

Для просмотра даты сканирования необходимо ввести: cache:[адрес проверяемой страницы]. *Этот метод работает для поисковых сетей Яндекс, Гугл, Винг.

Совет: Сравнивайте количество реальных URL и проиндексированных. Это помогает выявлять ошибки. К примеру, если на ресурсе 150 товаров, 15 подкатегорий и 10 инфостраниц, а в поиске всего 50 единиц из общего количества – поисковый робот не проверил большую часть информации с сайта.

4. Как отправить сайт на индексацию?

Необходимо добавить сайт в вебмастер Гугл и Яндекс, после чего добавить ссылку на XML карту в вебмастере.

Инструкция: Как добавить сайт в поисковые системы

Среди причин, почему индексировать сайт в Гугл не получается, выделяют ошибки SEO-оптимизации. К примеру, наличие некорректных ссылок, дублирование страниц, наличие неуникального контента, нет карты сайта.

– Автоматическое добавление в индекс

Если на сайте настроена автоматическая XML карта, то есть после создания страницы она автоматически попадает в перечень страниц, которые передаются как рекомендация для индексации в поисковые системы.

Также страницу можно проиндексировать в ручную путем отправки запроса на индексацию через вебмастер.

Ручная индексация сайта в Google проходит по следующей схеме:

– Заходите на сервис Гугл.Вебмастер;

– Заполняете URL в поисковой строке вверху сайта;

![]()

– И делаете запрос на индексацию.

Ручная индексация сайта в Яндекс проходит по следующей схеме:

Для ручного добавления в Yandex заходите в Yandex.Вебмастер. Для массового сканирования переходите в раздел панели. Допустимый лимит в сутки – 20 URL. Сроки проверки от 1 дня до 2 недель.

Для ускорения процесса в Mail.ru надо зайти в аддурилку сервиса. Настройка индекса в Нигма проходит также через аддурилку поисковика.

Хотите быстрее провести массовую проверку индексации страниц в Meta.ua? Для этого переходите по ссылке http://web.meta.ua/?action=add. Но для начала стоит зарегистрировать профиль в системе.

Для ускорения проверки в Bing – поисковик в англоязычном сегменте, необходимо проследовать по ссылке ручного добавления страниц. Там потребуется ввести капчу, что вы не робот.

5. От чего зависит индексация (факторы влияющие на индексацию)

Индексация сайта напрямую зависит от следующего набора факторов:

– Частота сканирования сайта роботом;

– Загруженность сервера сайта;

– Частота обновления сайта;

– Наличие корректной XML карты;

– Наличие внешних ссылок на сайте (ссылок с других сайтов).

6. Как ускорить индексацию сайта (инструкция)

Скорость индексации страница сайта зависит от многих параметров. Используйте следующею комбинацию:

1. Обязательная регистрация в вебмастерах;

Инструкция: Как добавить сайт в поисковые системы

2. Правильно оформите файл robots.txt;

Инструкция: Robots.txt: полное руководство по настройке

3. Создайте правильную карту сайта для поисковиков – XML карту, которая будет содержать все нужные страницы;

Инструкция: Карта сайта: инструкция по созданию правильной sitemap.XML и HTML карты сайта

4. Проверьте файл robots.txt, стоит запретить сканирование всех ненужных страниц сайта;

Инструкция: Проверка файла robots в Гугл

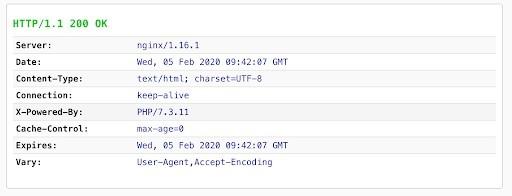

5. Проверьте корректность ответа сервера, все нужные страницы должны отдавать 200 код ответа сервера;

Например тут:

6. Проверьте корректность настройки мета-тегов, не запрещена ли индексация нужных страниц сайта;

7. Проверьте, корректность настройки канонических страниц сайта;

8. Добавьте карту сайта в вебмастера;

9. Разместите на сайт внешние ссылки;

Инструкция: Бесплатные ссылки: 25 способов получения бесплатных ссылок на сайт

10. Проработайте внутреннею перелинковку сайта;

11. Создавайте новый качественный контент регулярно.

Особенности ускоренной индексации сайтов поисковыми системами

Гугл анализирует новые URL немного быстрее, чем Яндекс. В среднем Google добавляет в поиск обновленные сведения за от 1-2 часов до 2-3 дней, что зависит от очереди сканирования сайта и краулингового бюджета.

Индексации страницы в Яндексе проходит иначе. Новые URL добавляются в выдачу после обновления поисковой системы. При этом, если до старта обновления робот успел провести проверку ресурса, то статья может оказаться в выдаче в течение нескольких часов.

7. Управление сканированием сайта

Проверка индексации в Яндексе, Google – важный этап продвижения сайта. Ведь поисковые пауки видят сайт не так, как читатели и способны находить страницы, на которые нет прямых ссылок на сайте. Если не ограничить сканирование того, что не нужно – в поисковики попадут те данные, которые, возможно, попасть в них не должны. К примеру, нет необходимости индексировать страницу с политикой конфиденциальности данных, страницу авторизации и так далее.

Важно! Существует лимит на количество страниц, которые посещает бот при обращение к сайту (краулинговый бюджет). Поэтому важно ненужные, мусорные данные выносить в список «исключения» для их обхода «пауками».

Для управления сканированием и индексацией сайта необходимо использовать файл Robots.txt. Это текстовый файл, сведения из которого считывает робот при обращение к серверу.

Robots.txt при работе использует ряд директив:

– User-agent – наименование робота, для которого работают прописанные правила.

– Allow – разрешение на сканирование.

– Disallow – запрет.

– Host – ссылка на главное зеркало.

– Sitemap – ссылка на карту сайта.

– Crawl-delay – временной промежуток задержки скачивания страниц.

– Clean-param – исключенные страницы.

User-agent указывает на поисковик, для которого работают правила. Если они касаются всех поисковых сетей, стоит поставить *. Если только для одной поисковой сети, прописываете ее: Yandex, GoogleBot, Bingbot, Slurp (это система Yahoo!).

Чаще всего вебмастера используют директиву – Disallow, необходимую для запрета индексации страниц, файлов, каталогов. Из поиска нужно исключать следующую информацию:

– Служебная документация, файлы, административную панель, CMS, ЛК клиента, корзину заказов.

– URL с малой информативностью, не требующие seo-продвижения, к примеру, чья-то биография или статистические сведения.

– Дублирование основных страниц. Если их не исключить, они попадут в блок за неуникальность.

Доверить проработку файла Robots.txt лучше специалисту. Но если вы решили заниматься ей самостоятельно – изучите детальную инструкцию по настройке robots.txt.

Важно! Поисковики по-разному воспринимают robots.txt. Яндекс воспринимает файл как правила. А Гугл – как рекомендацию к действиям.

8. Проблемы с индексированием сайта или частые ошибки

Индексация поисковыми системами может быть достаточно непростым процессом. С какими частыми проблемами можно столкнуться:

- Долгая индексация – новый большой сайт. Допустим 100 – 200 000 страниц. У сайта будет маленький краулинговый бюджет, сайт может индексироваться не один месяц.

- Часть проиндексировалась, часть нет. Недостаточный краулинговый бюджет, возможно плюс ненужные страницы, на которые робот тратит силы.

9. Почему не индексируется сайт? Частые ошибки

Новый сайт может быть не проиндексирован по следующим причинам:

– сайт не добавлен в вебмастера поисковых систем;

– у сайта отсутствует карта сайта;

– ссылка на карту сайта не добавлена в файле robots или в вебмастерах;

– сбои и сложности в работе сервера (к примеру, сервер отдает 500 ошибку);

– индексация сайта закрыта через robots.txt;

– индексация сайта закрыта через мета-теги;

– сайт забанен поисковой системой.

Почему не индексируется страница:

– сбои и сложности в работе сервера (к примеру, сервер отдает 500 ошибку);

– страница отдает ложный ответ сервера (к примеру 404 вместо 200 кода);

– недостаточный крауниговый бюджет и слишком много страниц на сайте (робот не доходит к странице);

– страница закрыта от индексации.

Проверяете все пункты и снова настраиваете индексацию сайта в Яндексе и Гугл.

10. Как закрыть сайт от индексации?

Если сайт еще не проиндексирован:

Простой способ закрыть сайт от индексации – это закрыть сайт от сканирования: разместить директиву Disallow: / в файле robots.txt, достаточно задать 2 строки:

User-agent:* #директива для выбора поисковика, где * это все поисковики;

Disallow: #запреты для поисковиков.

Сам текстовый файл должен находиться в корневой папке сайта. Установить его туда может разработчик ресурса.

Если сайт уже проиндексирован:

Разместите мета-тег robots на всех страницах сайта <meta name=”robots” content=”noindex” />.

(3 оценок, среднее: 3,67 из 5)

(3 оценок, среднее: 3,67 из 5)